hanlp库的使用!🐈

hanlp库的使用

1.安装

1 | |

1.1 多任务模型

1 | |

通过代码将模型下载到本地

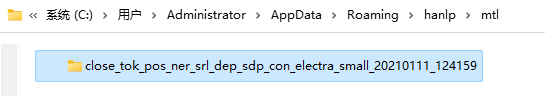

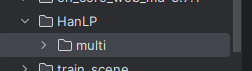

将模型移动到本地调用的位置

模型库:https://hanlp.hankcs.com/docs/api/hanlp/pretrained/mtl.html

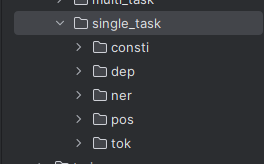

1.2 单任务模型

多任务学习的优势在于速度和显存,然而精度往往不如单任务模型。所以,HanLP预训练了许多单任务模型并设计了优雅的流水线模式将其组装起来。

1 | |

同多任务模型,将单任务模型保存到本地。

2.调用

2.1 多任务

2.1.1 批量分析

1 | |

2.1.2 可视化

1 | |

2.1.3 指定任务

分词:

1 | |

粗颗粒度分词:

1 | |

分词和PKU词性标注:

1 | |

粗颗粒度分词和PKU词性标注:

1 | |

分词和MSRA标准NER:

1 | |

分词、词性标注和依存句法分析:

1 | |

分词、词性标注和短语成分分析:

1 | |

语义依存分析:

1 | |

2.1.4 删除冗余任务

1 | |

2.1.5 自定义词典

先获取分词任务:

1 | |

以“商品和服务项目”为例,不做任何修改的情况:

1 | |

强制模式(强制模式优先输出正向最长匹配到的自定义词条):

1 | |

强制校正模式(匹配到的自定义词条替换为相应的分词结果):

1 | |

合并模式(合并模式的优先级低于统计模型,即dict_combine会在统计模型的分词结果上执行最长匹配并合并匹配到的词条):

1 | |

2.1.6 单词位置

HanLP支持输出每个单词在文本中的原始位置,以便用于搜索引擎等场景。在词法分析中,非语素字符(空格、换行、制表符等)会被剔除,此时需要额外的位置信息才能定位每个单词:

1 | |

2.2 单任务

1 | |

2.3 word2vec

2.3.1 加载模型

1 | |

2.3.2 输出向量

1 | |

2.3.3 计算相似度

1 | |

2.3.4 最相似单词

1 | |

Word2Vec 通常无法处理 OOV 或短语

Doc2Vec 与 Word2Vec 模型相反,可以通过平均一组单词来创建矢量化表示。要为 OOV 和短语启用 Doc2Vec,请传递 doc2vec=True :

1 | |

2.4 mlm

1 | |

1 | |

1 | |

hanlp库的使用!🐈

https://yangchuanzhi20.github.io/2024/04/09/人工智能/NLP/库的使用/hanlp库的使用/